Les membres de l’Afas publient régulièrement des articles. Ils sont à retrouver ici :

Jeanne Brugère-Picoux

Professeur honoraire de pathologie médicale du bétail et des animaux de basse-cour (Ecole nationale vétérinaire d’Alfort), membre de l’Académie nationale de médecine, ancienne présidente de l’Académie vétérinaire de France

L’annonce d’une contamination des œufs par le fipronil a beaucoup surpris la filière avicole puisque l’utilisation de ce produit était interdite sur tout animal (ou ses produits) pouvant être destiné à une consommation humaine. Le fipronil est utilisé couramment comme insecticide chez les animaux de compagnie mais aussi comme produit biocide destiné à lutter contre les fourmis ou les cafards. L’utilisation frauduleuse de cet antiparasitaire était d’autant plus scandaleuse qu’elle concernait un produit « bio » à base de plantes destiné à lutter contre les poux rouges dans les élevages de poules pondeuses ! Ainsi, contrairement aux affirmations de quelques écologistes ou organisations de protection animale, les élevages bios n’étaient pas les plus protégés par cette fraude.

Chronologie d’une fraude scandaleuse

La contamination des œufs néerlandais daterait de novembre 2016 selon le ministre belge de l’Agriculture, Denis Ducarme. Cependant la première notification de résultats non conformes pour le fipronil (taux de résidu dépassant la limite maximale de résidu ou LMR, fixée en Europe à 0,005 mg/kg) date du 2 juin 2017 en Belgique. L’alerte avait été donnée à la suite d’un autocontrôle réalisé par une casserie à l'Agence fédérale pour la sécurité de la chaîne alimentaire (Afsca), l’équivalent belge de l’Agence nationale de sécurité sanitaire de l’alimentation, de l’environnement et du travail (Anses) en France. Ces œufs provenaient d'une exploitation de poules pondeuses en Belgique. Cette détection fortuite conduit l’Afsca à bloquer la production de l’exploitation en cause dès le lendemain et la saisie des ovoproduits provenant de l’élevage, puis à leur destruction mi-juin. Très rapidement, un traitement contre les poux rouges avec le « Dega-16 » est suspecté, ce produit néerlandais, à base de menthol et d’eucalyptus, étant distribué par la société Chickfriend, dont les deux fondateurs font maintenant l'objet d'une enquête criminelle. Jusqu’à la fin du mois de juillet, les contrôles effectués en Belgique confirment la présence du fipronil dans les œufs sans que pour autant les autres pays européens en soient officiellement informés.

C’est seulement à partir du 4 août 2017 que le scandale est connu de tous avec l’annonce de millions d’œufs retirés des rayons dans les supermarchés néerlandais et allemands. Le syndicat néerlandais des éleveurs de volailles compte alors « plusieurs millions d’euros de pertes ». Progressivement, la traçabilité des ovoproduits permet de découvrir l’extension de la contamination dans 17 autres pays européens, dont la France ainsi qu’à Hong Kong. Plusieurs élevages néerlandais sont bloqués, les œufs sont détruits ainsi que les poules pondeuses. En France, on a découvert progressivement que plusieurs établissements étaient concernés par des importations néerlandaises. Au 14 août 2017, on a pu ainsi identifier 14 établissements de transformation d’œufs ou d’ovoproduits, 2 centres de conditionnement d’œufs et 40 grossistes, et les analyses en cours permettront ultérieurement de connaître les produits confirmés. Près de 45 tonnes d’ovoproduits pouvant être contaminés ont été ainsi importés en France. Des œufs en coquille contaminés ont été aussi importés. Il s’agissait de 196 000 œufs en provenance de Belgique qui ont été mis sur le marché entre le 16 avril et le 2 mai et qui ont été consommés. Un deuxième lot (environ 48 000 œufs), venant des Pays-Bas, portant le code 0 NL 4365101(il s’agissait donc d’œufs « bios »), ont été mis en vente entre le 19 et le 28 juillet chez Leader Price, qui a procédé au retrait des œufs encore en rayon dès qu’il a eu connaissance d’un risque de contamination.

Le fipronil est « modérément toxique »

Dès 2004, le fipronil utilisé pour l’enrobage des semis (sous le nom de Régent) avait été suspecté d’être responsable d’une hausse de mortalité chez les abeilles françaises. Il fut alors interdit en France mais les rapports ultérieurs (dont celui de l’EFSA, l’Agence européenne de sécurité alimentaire en 2013) n’ont jamais pu démontrer formellement cette toxicité pour les abeilles. Mais la controverse existe et il a fallu attendre 2014 pour que cette interdiction concerne aussi les autres pays européens pour plusieurs produits végétaux destinés à l’alimentation animale ou attractifs pour les abeilles [1].

En grande quantité, le fipronil est considéré comme « modérément toxique » pour l’Homme par l’Organisation mondiale de la santé (OMS). L’Anses l’a confirmé dans son rapport du 10 août 2017. Les cas d’intoxication connus chez l’Homme (d’origine accidentelle ou volontaire) n’ont pas permis d’observer les effets neurotoxiques signalés chez les animaux de laboratoire lors des essais de toxicité ou une mortalité mais tout au plus des troubles digestifs de gravité moyenne. En tenant compte de la dose de fipronil la plus importante ayant été détectée dans un œuf contaminé (soit 1,2 mg/kg), l’Anses a calculé combien d’œufs pouvaient être consommés par jour pour que l’exposition reste inférieure à la dose de référence aiguë (ou acute reference dose, ARfD) [2]. Il s’agit d’un œuf ou de dix œufs par jour pour un enfant ou un adulte respectivement. Ces doses peuvent être multipliées par dix puisque des doses équivalentes à 10 ARfD n’ont pas permis d’observer un effet chez l’Homme, y compris chez l’enfant (soit, par exemple, près de cent œufs fortement contaminés pour un adulte par jour). En ce qui concerne la viande, la concentration maximale retrouvée dans le muscle des poules a été de 0,175 mg/kg de muscle, soit une consommation journalière de plusieurs kilogrammes de viande pour dépasser l’ARfD.

En ce qui concerne le risque lié à un effet cumulatif, il n’existe pas de données permettant d’évoquer un tel risque pour les produits ayant été mis sur le marché en France. D’ailleurs, les analyses en cours sur tous les produits suspects d’avoir été contaminés et leur saisie si les traces de fipronil dépassent la LMR [3] permettront de rassurer le consommateur. Si le consommateur peut regretter que l’on n’ait pas eu immédiatement la liste de ces produits suspects, on peut aussi parfaitement comprendre que le ministère de l’Agriculture attende les résultats des analyses pour fournir cette liste ne concernant que les produits où la LMR est dépassée pour les retirer définitivement du marché, puisqu’il s’agit d’une fraude et non d’un risque d’intoxication.

Seules les enquêtes en cours des circuits commerciaux des œufs et des ovoproduits, voire du produit « bio » frauduleux pourront démontrer l’importance de cette contamination en Europe et peut-être dans d’autres pays puis Hong Kong a été également touché. Il faut surtout espérer que la fraude n’aura eu lieu que dans la société néerlandaise incriminée et que le fipronil n’aura pas été utilisé dans d’autres circuits destinés à lutter contre les poux rouges, ectoparasites hématophages tant redoutés dans les élevages de pondeuses.

En conclusion, ce problème des œufs contaminés est un problème essentiellement économique et non sanitaire pour la filière œuf et pour l’Europe, et on ne connaît pas encore les conséquences économiques et judiciaires de ce scandale. Cela n’est pas sans nous rappeler la contamination frauduleuse des aliments destinés aux volailles par de la dioxine en Belgique il y a plusieurs années. A l’époque le consommateur refusait de manger du poulet alors que la filière dinde, non boycottée, avait reçu les mêmes aliments contaminés…

Serge Chambaud

Président de l'AFAS

La société des ingénieurs et scientifiques de France (IESF) vient de publier les résultats de son enquête nationale annuelle sur les ingénieurs, menée avec l'aide des associations d'anciens élèves des écoles d'ingénieurs.

La population d’ingénieurs, qui dépasse cette année le million, continue de croître de 4 % par an.

77 % des ingénieurs sont satisfaits ou très satisfaits de leur emploi (contre 44 % en 2010).

Ils sont très majoritairement cadres (96 %), en CDI (94%), dans le secteur privé (79 %) et salariés (75 %). Leur salaire annuel brut médian – qui triple au cours de la carrière – est de 56 000 € (17 % de plus que celui de l’ensemble des cadres), avec une durée de travail hebdomadaire de 45 heures ou plus pour 56 % d'entre eux.

Leur taux de chômage reste faible : 3,9 % (2,8 % en excluant les jeunes diplômés à la recherche d’un premier emploi). Le recrutement demeure relativement facile, dans un marché globalement équilibré malgré une tension particulière apparue dans le secteur du numérique.

49 % des ingénieurs travaillent en province et DOM, 35 % en Ile-de-France et 16 % à l'étranger – dont 35% n’envisagent pas de revenir en France. Les expatriations, qui avaient progressé autour de 2010, semblent marquer le pas. La Suisse demeure la première destination, suivie par les Etats-Unis, l’Allemagne et le Royaume-Uni.

Des mutations sectorielles sont observées en 2016 : les effectifs d’ingénieurs baissent légèrement dans l'industrie et progressent fortement dans les activités de « Conseil en technologie, logiciels et services informatiques » (+ 16 %) et de « Conseil en stratégie » (+ 11 %).

La population d’ingénieurs se féminise lentement (4 % de plus par décennie) ; en 2016, on compte 20,3 % de femmes ingénieurs et 28,5 % dans la dernière promo d’ingénieurs diplômés.

Le plafond de verre est toujours présent, avec moins de postes d'encadrement élevés pour les femmes ingénieurs, des rémunérations inférieures à niveau hiérarchique égal, et près de deux fois plus de CDD.

La progression de la féminisation est forte dans les secteurs de l’agriculture, des industries (hors celles du transport et des machines armements), de l’eau, du gaz et de l’électricité, ainsi que dans les BTP et les sociétés de service. Seul le secteur « Banques, assurances » est à contre-courant de la tendance générale, avec une proportion de femmes en diminution.

Chez les moins de 30 ans, les femmes sont désormais majoritaires dans les industries agro-alimentaires, le secteur « Eau, assainissement, dépollution », l’industrie pharmaceutique et le secteur « Agriculture, sylviculture et pêche ».

Enfin, deux thématiques particulières ont été étudiées dans l’enquête 2017 :

- La formation tout au long de la vie professionnelle

44 % des ingénieurs ont suivi une formation professionnelle en 2016 (contre 34 % en 2009). L’absence de formations est fortement ressentie dans les TPE, où seulement 27 % des ingénieurs y ont eu accès (contre 51,3 % dans les grandes entreprises).

Deux types de formations – emblématiques du déroulé de carrière d’un ingénieur – sont privilégiées : « scientifiques et techniques dans la spécialité » et « management et leadership ». Elles restent effectuées à 75 % en présentiel, malgré le développement de nouveaux modes de formation (e-learning, MOOC, classe virtuelle). - La transformation numérique des entreprises

43% des ingénieurs estiment que la transformation numérique est une révolution qui va engendrer des changements profonds, principalement dans les secteurs du tertiaire et de l’industrie.

50 % des ingénieurs se sentent complètement armés pour aborder cette mutation, contre 8 % pas du tout ; les moins de 30 ans s’estimant, sans surprise, plus souvent complètement armés.

La transformation numérique est fortement engagée dans les grandes entreprises, deux fois plus que dans les entreprises de taille intermédiaire, et trois à quatre fois plus que dans les PME et TPE.

Jeanne Brugère-Picoux

Professeur honoraire de pathologie médicale du bétail et des animaux de basse-cour (Ecole nationale vétérinaire d’Alfort), membre de l’Académie nationale de médecine, ancienne présidente de l’Académie vétérinaire de France

Au mois de mars 2017, à Tokyo, un bébé âgé de 6 mois est mort après avoir ingéré du miel. Il s’agit du premier cas mortel de botulisme au Japon depuis 1986, les cas déclarés (une trentaine) ayant pu être traités. Le bébé avait reçu 2 fois par jour pendant un mois un jus de fruit sucré avec du miel, les parents méconnaissant ce risque de botulisme lié au miel.

Les cas mortels de botulisme infantile sont rares mais il peut s’agir de la forme la plus fréquente de cette maladie humaine[1] dans certains pays comme les Etats-Unis, où l’on observe en moyenne près de 110 cas par an (2419 cas sur la période 1976-2006). Par exemple, sur les 199 cas de botulisme confirmés et les 14 cas probables observés par le CDC d’Atlanta en 2015, 141 (soit 71%) étaient infantiles, la moyenne d’âge étant de 2,7 mois (on peut noter que cette moyenne d’âge coïncide avec celle de la mort subite des nouveau-nés). En France, le botulisme infantile est très rare (7 cas déclarés entre 1991 et 2009, 2 cas confirmés pour la période 2010-2012)[2, 3]. Cependant, suite à l’augmentation du nombre de cas de botulisme infantile depuis 2004, l’Anses [4] a rappelé « qu'il est absolument déconseillé de donner du miel, quelle que soit son origine, aux nourrissons de moins d'un an ».

Si le miel peut être incriminé dans environ 15% des cas américains, on ne connaît pas l’origine de la contamination par les spores pour les autres cas (contamination de l’aliment par le sol ou les poussières) alors qu’en Europe, on considère généralement que le botulisme infantile est lié principalement à la consommation de miel.

Le botulisme est rare mais potentiellement grave, d’où son inscription sur la liste des maladies à déclaration obligatoire en France. Il est justifié d’en connaître les symptômes pour mettre en place rapidement un traitement symptomatique et prévenir cette maladie, en particulier chez le nouveau-né.

L’enfant âgé de moins d’un an est particulièrement sensible s’il ingère des spores de Clostridium botulinum car son système immunitaire n’est pas encore suffisamment adapté pour le défendre. Les spores de C. botulinum peuvent ainsi se développer dans l’intestin et y produire la toxine botulique provoquant la maladie. Le symptôme le plus commun et le plus précoce du botulisme infantile est la constipation. D'autres symptômes décrivent un état de faiblesse générale : faible réflexe de succion, irritabilité, manque d'expression faciale, et perte de contrôle des mouvements de la tête. La paralysie du diaphragme peut toutefois entraîner des troubles respiratoires, nécessitant d’urgence une prise en charge médicalisée. La plupart des cas de botulisme infantile nécessite une hospitalisation très longue sous assistance respiratoire. Cependant, dans les pays occidentaux, les cas mortels sont extrêmement rares. Après l’âge d’un an, les défenses de l’enfant sont plus efficaces et lui permettent, par lui-même, d’éliminer les spores.

En conclusion, le risque de botulisme chez l’enfant âgé de moins d’un an n’est malheureusement pas assez connu et il est regrettable qu’il n’y ait pas une obligation d’avertissement pour ce danger sur les pots de miel, comme cela se fait dans certains pays en Europe du Nord.

Alain Foucault

Professeur émérite du Muséum national d'histoire naturelle (Paris)

Le réchauffement climatique avait marqué un palier autour de 2005, mais il a repris de plus belle, et selon l’Organisation météorologique mondiale (OMM), l’année 2016 le montre sans ambiguïté : température moyenne record, banquise exceptionnellement réduite et poursuite inexorable de la hausse du niveau de la mer et du réchauffement des océans. On peut s’en convaincre en lisant la déclaration annuelle sur l'état du climat mondial que l'OMM a publiée en prévision de la Journée météorologique mondiale célébrée le 23 mars 2017.

Comme l’a souligné le secrétaire général de l'OMM, Petteri Taalas, « Ce compte rendu confirme que l'année 2016 est la plus chaude qui ait jamais été enregistrée : la hausse de la température par rapport à l'époque préindustrielle atteint, chose remarquable, 1,1 °C, soit 0,06 °C de plus que le record précédent établi en 2015. Cette augmentation de la température moyenne s'inscrit dans la logique des autres changements intervenant dans le système climatique ».

Claudine Hermann

Présidente d'honneur de l'association Femmes & Sciences

L’association Femmes & Sciences, qui a pour objectifs de renforcer la position des femmes dans les métiers scientifiques et techniques et d’inciter les jeunes, et plus particulièrement les jeunes filles, à s’orienter vers ces carrières, est très concernée par les débouchés des études supérieures scientifiques.

Elle a organisé, le 5 novembre 2016 à Mines ParisTech, son colloque annuel sur le thème : « Femmes scientifiques et entreprises. Etat des lieux et initiatives », en partenariat avec le ministère de l’Éducation nationale, de l’Enseignement supérieur et de la Recherche et du ministère des Familles, de l’Enfance et des Droits des femmes, et avec la collaboration de la Mission pour la Place des femmes au CNRS.

Ce colloque s’est focalisé sur la situation des femmes scientifiques, ingénieures ou techniciennes, en entreprise, à toutes les étapes de la vie professionnelle. Après un état de la situation, différentes initiatives ont été présentées sur quatre grands thèmes : l’égalité professionnelle, l’insertion professionnelle, les réseaux de femmes et la création d’entreprises au féminin. Des témoignages de représentant-e-s d’entreprises de secteurs variés ont été complétés par des exposés de spécialistes des relations femmes et entreprises.

L’événement a rassemblé plus de deux cents personnes de multiples horizons.

Les actes du colloque sont disponibles sur le site de l'association Femmes & Sciences.

Jeanne Brugère-Picoux

Professeur honoraire de pathologie médicale du bétail et des animaux de basse-cour (Ecole nationale vétérinaire d’Alfort), membre de l’Académie nationale de médecine, ancienne présidente de l’Académie vétérinaire de France

Après la mort par encéphalite entre 2011 et 2013 de trois propriétaires d’un écureuil multicolore (Sciurus variegatoides) en Allemagne, un nouveau virus zoonotique, le « variegated squirrel bornavirus 1 » ou VSBV-1 a été identifié en 2015. Dans cette famille des Bornaviridae, les autres bornavirus des mammifères (Mammalian 1 bornavirus ou BoDV-1 et -2) et des oiseaux (Passeriform 1/2 bornavirus, Psittaciform 1/2 bornavirus, Waterbird 1 bornavirus) ne sont pas considérés comme étant zoonotiques. Une étude récente [1] réalisée sur 468 écureuils [14 espèces correspondant à des animaux de compagnie en Allemagne (339) et aux Pays-Bas (49 chez 4 propriétaires) ou trouvés morts sur les routes au Royaume-Uni (20)] a permis de détecter 11 animaux positifs asymptomatiques [9 en Allemagne et 2 aux Pays-Bas dont 6 écureuils multicolores et 5 écureuils arboricoles de Prévost (Callosciurus prevostii) soit une prévalence de 3,3% et de 8,8% respectivement]. Ces écureuils positifs ont été euthanasiés et l’antigène viral a été mis en évidence en grande quantité dans le système central, la cavité buccale et la peau, indiquant la possibilité d’une transmission à l’Homme par griffure ou par morsure.

Ces résultats témoignent de l’intérêt d’un dépistage du bornavirus zoonotique VSBV-1 chez ces deux espèces d’écureuils pouvant être en contact avec le public, notamment dans les jardins zoologiques. Rappelons que ces deux espèces d’écureuils ne sont pas de nouveaux animaux de compagnie (NAC) en France.

Jeanne Brugère-Picoux

Professeur honoraire de pathologie médicale du bétail et des animaux de basse-cour (Ecole nationale vétérinaire d’Alfort), membre de l’Académie nationale de médecine, ancienne présidente de l’Académie vétérinaire de France

L’annonce récente d’un premier cas clinique de la forme variante de la maladie de Creutzfeldt-Jakob (vMCJ) liée à l’encéphalopathie spongiforme bovine (ESB) chez un sujet britannique hétérozygote 129MV ne peut que relancer l’hypothèse d’une seconde vague de vMCJ au Royaume-Uni comme en France. Le nombre de nouveaux malades ne devrait toutefois pas être supérieur à celui enregistré lors de la première vague.

Il y a bientôt trois décennies que l’ESB est apparue au Royaume-Uni, à l’origine d’une des crises majeures que nous ayons connues dans le domaine de l’agro-alimentaire du fait de l’annonce en mars 1996 de la possible transmission du prion bovin (souche ESB classique ou ESB-C) à l’Homme, à l’origine des 231 cas de la forme variante de la maladie de Creutzfeldt-Jakob (vMCJ) [1].

Extinction apparente de l’épidémie de vMCJ

La mise en œuvre progressive de mesures drastiques, destinées à éviter une contamination alimentaire du cheptel bovin et une transmission à l’Homme, a permis d’observer la disparition progressive des cas d’ESB-C dans de nombreux pays mais aussi la découverte d’autres souches d’ESB dites atypiques, la maladie étant devenue à nouveau rare dans les cheptels bovins.

L’épidémie de vMCJ semblait s’être éteinte du fait de l’absence de nouveaux cas cliniques de vMCJ depuis 2013 et 2014 dans les deux pays les plus touchés, le Royaume-Uni et la France respectivement.

Jusqu’alors, tous les cas étaient homozygotes méthionine-méthionine sur le codon 129 (129MM), cette homozygotie étant connue pour favoriser de plus courtes durées d’incubation de la MCJ, par comparaison avec les sujets hétérozygotes méthionine-valine (129MV).

L’annonce récente d’un premier cas clinique de vMCJ chez un sujet britannique hétérozygote 129MV [2] ne peut que relancer l’hypothèse d’une seconde vague de vMCJ au Royaume-Uni comme en France, celle-ci présentant au pire les mêmes données numériques que la première épidémie.

Temps moyen d’incubation de 16,5 ans chez les homozygotes

Après l’annonce en mars 1996 des premiers cas de vMCJ, on a pu observer une augmentation progressive de leur nombre jusqu’à l’année 2000 au Royaume-Uni (28 cas) puis leur diminution régulière, le dernier cas étant décédé en 2016, soit un total de 178 cas.

Pour ces cas, il faut noter que :

- jusqu’en 2013, seuls les sujets homozygotes étaient atteints, avec un temps d’incubation moyen estimé de 16,5 années ;

- 3 cas sont d’origine iatrogène par transfusion sanguine, avec des temps d’incubation plus courts, entre 6,5 et 8 ans du fait de l’absence d’une barrière d’espèce ;

- le cas hétérozygote décédé en février 2016 était âgé de 36 ans ; il avait présenté les premiers symptômes d’une MCJ sporadique (forme classique de la MCJ) en août 2015 mais les lésions histologiques de l’encéphale et l’identification biochimique de la souche ESB-C ont permis de reconnaître une vMCJ ;

- jusqu’alors on ne connaissait qu’un cas de suspicion clinique de vMCJ en 2009 sur un sujet hétérozygote mais celui-ci n’avait pas pu être confirmé par une autopsie ; en revanche, on a pu démonter l’infectiosité de la rate d’un autre sujet britannique hémophile hétérozygote, contaminé par des produits sanguins (facteur VIII) et décédé sans avoir développé la maladie ; enfin, une étude rétrospective réalisée au Royaume-Uni sur des prélèvements d’amygdales et d’appendices a aussi démontré que les trois génotypes humains pouvaient être porteurs asymptomatiques de la vMCJ dans la proportion d’un sujet britannique sur 2 000 à 4 000 personnes.

La France, deuxième pays le plus touché

La France a été le deuxième pays le plus touché avec 27 cas de vMCJ.

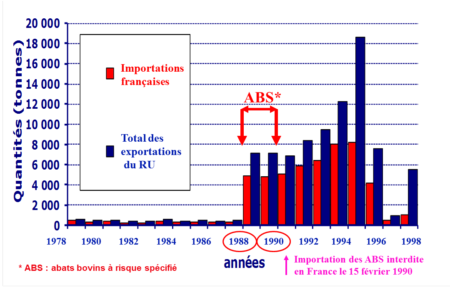

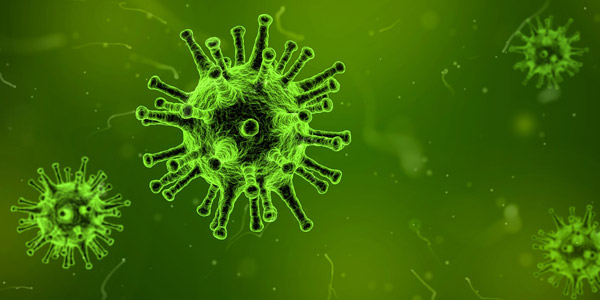

Les épidémiologistes considèrent que l’évolution des cas français, avec un pic en 2005, est en corrélation avec les exportations de produits bovins britanniques : les exportations d’abats de bovins britanniques avaient été multipliées par 20 vers les années 1988-1989, passant de 300 tonnes à 6 000 tonnes par an, certains de ces abats ayant pourtant été déconseillés pour les aliments destinés aux bébés par le "comité Southwood" créé en mai 1988 au Royaume-Uni [3] (fig. 1).

Il en est vraisemblablement de même pour les dix autres pays touchés avec un total de 26 cas dont certains correspondent aussi à des personnes ayant séjourné au Royaume-Uni : 5 cas en Espagne, dont le seul cas familial où une mère et son fils ont déclaré la maladie ; 4 cas en Irlande et aux Etats-Unis ; 3 cas aux Pays-Bas et en Italie ; 2 cas au Canada et au Portugal ; un seul cas au Japon, en Arabie Saoudite et à Taïwan (fig. 2)

Les homozygotes ne sont plus les seuls susceptibles à l’agent bovin

On connaissait l’importance des polymorphismes [méthionine (M)-valine (V)] sur le codon 129 sur le temps d’incubation de la MCJ dans sa forme sporadique ou iatrogène ainsi que sur le Kuru, autre forme d’encéphalopathie spongiforme transmissible par cannibalisme rituel, l’hétérozygotie 129MV étant associée à un temps de survie plus importante.

La distribution normale de ces génotypes est, selon les auteurs, de 42 % 129MM, 46 à 47 % 129MV et 11 à 12 % 129VV.

Par ailleurs, des expériences de transmission à des souris transgéniques surexprimant la protéine prion humaine et portant les différents génotypes sur le codon 129 ont montré une sensibilité à la souche vMCJ dans l’ordre décroissant MM > MV > VV.

D’autres études utilisant des techniques moléculaires ont confirmé ce risque décroissant avec l’agent bovin. Les individus 129MV et 129VV ont donc pu être contaminés et demeurer infectés asymptomatiques avec un temps d’incubation plus long où l’on pouvait espérer qu’il dépasserait leur durée de vie.

Outre ce risque de seconde vague de vMCJ, une autre question peut être posée quant au diagnostic clinique de cette maladie chez un sujet hétérozygote (qui avait présenté les symptômes d’une MCJ sporadique) et la sous-estimation du nombre de vMCJ si des examens post mortem ne sont pas effectués pour exclure un cas de vMCJ.

Claudine Hermann

Membre du Conseil d’administration de l’AFAS

Pour réaliser l’excellence en science et en innovation, les talents de tous, femmes et hommes, sont nécessaires. Mais les femmes sont encore trop peu nombreuses en sciences, technologie, ingénierie et mathématiques (STIM) ainsi qu’en informatique, et trop peu de filles s’engagent dans les études correspondantes (biologie et médecine constituent des exceptions). De plus, les femmes scientifiques n’ont pas assez accès aux postes de décision. Ces constats sont maintenant bien connus, il convient que tous les acteurs passent aux actions concrètes.

C’est pourquoi l’assemblée générale des Nations Unies a décidé en 2015 que le 11 février serait désormais la Journée internationale des femmes et des filles en sciences ; la première célébration a eu lieu en 2016. Le 11 février 2017, un colloque d’une matinée s’est tenu au siège de l’Unesco à Paris, avec deux sessions : « Au-delà des chiffres : renforcer les capacités des femmes et des filles en sciences et les rendre autonomes » et « Femmes, science et société : les faits ».

La question de la place des femmes et filles en STIM est à l’ordre du jour de nombreux cercles.

Au niveau européen, la Commission a financé depuis 2000 de nombreux projets, pour faire des états des lieux (en particulier par la publication régulière de statistiques sexuées, voir She Figures 2015), soutenir les femmes scientifiques, améliorer la culture scientifique pour les jeunes et, depuis quelques années, pour changer les institutions de recherche en y améliorant l’égalité femmes-hommes.

Au niveau des femmes elles-mêmes, la Plateforme européenne des femmes scientifiques EPWS, une association internationale sans but lucratif qui rassemble des associations de femmes scientifiques en Europe et au-delà, représente les intérêts de 12 000 d’entre elles au niveau européen.

Les gouvernements de nombreux pays d’Europe ont mis en place des programmes pour encourager les jeunes, filles et garçons, à s’orienter vers les sciences et/ou à penser à des métiers non traditionnels (voir par exemple en France la campagne sur la mixité des métiers).

Des associations cherchent à promouvoir les sciences auprès des jeunes, comme l’a fait l’AFAS à l’automne 2016 en organisant le Carrousel des métiers au Cnam. Les associations de femmes scientifiques vont à la rencontre des jeunes dans les classes : ainsi au Portugal, Amonet ; au Royaume-Uni, le Groupe Femmes en physique de l’Institut de physique (société savante britannique pour la physique), mène l’opération Physicists in Primary Schools dans les écoles primaires ; en France les associations Femmes & Sciences, Femmes & Mathématiques et Femmes Ingénieurs. Les femmes scientifiques s’adressent à la fois aux filles et aux garçons mais comme ce sont des femmes qui parlent, les filles peuvent plus facilement se représenter dans ces métiers.

Promouvoir une meilleure égalité entre les femmes et les hommes dans les métiers scientifiques et techniques, entre les filles et les garçons dans les études menant à ces professions, est indispensable pour profiter de tous les talents et assurer l’avenir de nos pays.

Jeanne Brugère-Picoux

Professeur honoraire de pathologie médicale du bétail et des animaux de basse-cour (Ecole nationale vétérinaire d’Alfort), membre de l’Académie nationale de médecine, ancienne présidente de l’Académie vétérinaire de France

Pour la première fois, les Américains ont annoncé en décembre dernier la contamination possible d’un vétérinaire new-yorkais par un virus H7N2 après un contact avec les chats d’un refuge dans l’île de Manhattan. Ce vétérinaire a présenté des troubles respiratoires modérés avec une guérison rapide. Plus d’une centaine de chats hébergés dans divers refuges de l’île ont été atteints par ce virus aviaire classé faiblement pathogène avec des troubles respiratoires modérés évoluant vers la guérison en l’espace d’une semaine (un seul chat est mort). Le contrôle de 350 personnes ayant pu être en contact avec les chats des divers refuges n’a pas permis de détecter d’autres contaminations humaines. Bien que l’on sache que l’Homme peut être sensible au virus influenza de sous-type H7, que celui-ci soit hautement pathogène (HP) ou faiblement pathogène (FP), ce cas de contamination d’un virus H7N2 du chat à l’Homme doit être considéré comme exceptionnel puisqu’il est unique et qu’il n’y a pas eu d’autres transmissions du chat à l’Homme ou de transmission interhumaine ultérieure avec un tel virus.

Cette annonce nous amène à nous poser la question du risque de transmission zoonotique d’un virus influenza aviaire. Ce risque est connu pour les virus de sous-types H5, H7 et H1.

Les virus influenza A peuvent être isolés chez différentes espèces animales (oiseaux, porc, baleine, cheval, phoque, chat, chien), les oiseaux sauvages étant considérés comme étant à l’origine des contaminations. Ces virus sont classés en sous-types en fonction de deux protéines situées à leur surface: l'hémagglutinine (H) et la neuraminidase (N). Il existe 18 sous-types d'hémagglutinine et 11 sous-types de neuraminidase. Cependant les sous-types H17N10 et H18N11 ne sont pas hébergés par les oiseaux mais par les chauves-souris. Seuls les virus H5 et H7 peuvent provoquer une peste aviaire en devenant HP pour les volailles, notamment les dindes et les poulets mais certains, comme le virus HP H5N8 sévissant actuellement en Europe, peuvent être exceptionnellement très virulents chez les anatidés.

En règle générale, les contaminations humaines par des virus H5 et H7 n’étaient pas considérées comme des zoonoses. Ce n’est qu’après les infections humaines par le virus HP de sous-type H5N1 épizootique ayant tué six personnes à Hong-Kong en 1997 (de 2003 au 19 décembre 2016, il y a eu 856 cas humains dont 452 morts [1] que la peste aviaire a été classée en tant que zoonose.

C’est aussi à l’occasion de cette épizootie que l’on a eu la surprise de découvrir que des félidés pouvaient être sensibles à ce virus HP H5N1, d’abord en 2004 en Thaïlande chez des félidés sauvages (deux tigres et deux léopards) dans un zoo puis en Allemagne (avec la mortalité de trois chats dans l’île de Rügen) et en Autriche (3 chats dont deux guérisons) en 2006. L’annonce très médiatique de cette contamination féline a été à l’origine d’une panique injustifiée chez certains propriétaires de chats, notamment en Allemagne, et de recommandations souvent extrêmes de confinement des chats dans d’autres pays européens.

Des cas de contaminations lors d’une peste aviaire due à un virus H7 ont pu être aussi observés dans le passé. Par exemple, l’émergence d’un grand nombre de conjonctivites humaines et d’un cas mortel (peut-être dû en fait à une chlamydiose) lors d’une épizootie de peste aviaire hollandaise due à un virus HP H7N7, au printemps 2003, passa presque inaperçue du fait de l’importance médiatique du syndrome respiratoire aigu sévère (SRAS) sévissant en Asie et au Canada au même moment. Des cas isolés de contamination humaine par des virus influenza HP de sous-types H7N2 et H7N3 ont également signalés aux Etats-Unis en 2002 et au Canada en 2004 respectivement, à la suite d’un contact avec des volailles atteintes. Un autre exemple plus récent a montré la possibilité d’une contamination humaine en Asie (le plus souvent lors de la visite de marchés de volailles vivantes) par un virus aviaire faiblement pathogène H7N9 (de 2013 à 2015, il y a eu 681 cas humains déclarés dont 275 décès [2].

Enfin, ce n’est pas la première fois que l’on observe la transmission à l’Homme d’un virus influenza H7 par une espèce non aviaire : ce fut le cas en 1980 aux Etats-Unis avec un virus H7N7 transmis par le phoque.

Concernant les virus influenza de sous-type H1, le risque zoonotique est connu depuis longtemps avec l’espèce porcine, la grippe du porc ayant toujours été classée dans les zoonoses. Bien que l’on connaissait depuis longtemps la sensibilité de la dinde à ce sous-type, avec des symptômes respiratoires modérés et une chute du taux de ponte, il a fallu la pandémie grippale due au virus H1N1 en 2009 pour que l’on découvre la possibilité d’une transmission de cette espèce à l’Homme ou inversement. Enfin, lors de la pandémie mondiale de 2009 due à un virus H1N1, on a aussi observé la contamination de plusieurs chats en Amérique du Nord comme en Europe ou en Chine sans que l’on ait pu démontrer une transmission du chat à l’Homme.

En conclusion, en dehors de la grippe porcine due au virus aviaire de sous-type H1, le risque zoonotique des virus influenza aviaires de sous-type H5 et H7 peut être considéré comme faible ou exceptionnel (selon les exemples précités) tant que l’on n’observera pas une forte contagiosité et une transmission interhumaine.

Alain Delacroix

Ancien professeur titulaire de la chaire "Chimie industrielle - Génie des procédés" du Conservatoire national des arts et métiers

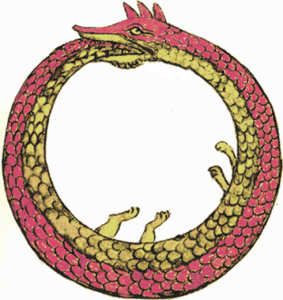

L’ouroboros, représenté par un serpent qui se mord la queue, est un symbole présent déjà en Egypte seize siècles avant notre ère. Il représente le cycle du temps, ou la résurrection ou encore l’autodestruction. Pour les alchimistes, il est le cycle de vie avec la naissance et la mort.

Zozime, le célèbre alchimiste, a dit cette phrase non moins célèbre : « Un [est] le Tout ; et si l’Un ne contient pas le Tout, le Tout n’est rien… ». Sachant que Un est l’ouroboros, la signification devient claire ! Quant à Kékulé, il semble que sa structure du benzène lui aurait été inspirée par l’ouroboros.

Les chimistes, comme le mythe, ont réussi à cycliser des molécules de tailles moyennes en utilisant deux sites réactifs, l’un étant la tête et l’autre la queue. En faisant cela, ils se sont rendu compte que très rarement et au hasard, deux cycles pouvaient s’imbriquer l’un dans l’autre. Cette méthode dite statistique a un très mauvais rendement, mais on peut penser que cette structure moléculaire étrange devrait avoir de nouvelles propriétés très intéressantes. Alors pour augmenter ce rendement, on a utilisé des techniques très sophistiquées utilisant des préorganisations moléculaires à l’aide d’interactions de type hydrogène ou coulombienne ou encore à l’aide d’un métal de transition. Maintenant, les rendements peuvent atteindre 90%.

Ces cycles imbriqués s’appellent des caténanes et c’est Pierre Sauvage, de l’université de Strasbourg, notre nouveau prix Nobel, qui a initié ces recherches dans les années quatre-vingt. Il est possible de créer maintenant des structures en formes de bretzel ou de menottes. On a même réussi à faire l’olympiadane, basé sur cinq cycles ayant globalement la forme des anneaux olympiques.

Ces nouveaux assemblages moléculaires sont susceptibles de tourner les uns dans les autres, et en utilisant divers sites actifs, on peut à volonté faire tourner ou arrêter la rotation. On réalise alors un interrupteur moléculaire. Avec les mêmes techniques, on peut fabriquer des rotaxanes. Dans ce cas, une molécule linéaire passe au travers d’un cycle, et pour qu’elle ne s’en échappe pas, on lui fixe à chaque extrémité une « grosseur » de taille supérieure à celle du cycle. La partie centrale ressemble à un haltère et le cycle peut tourner autour ou aller d’un bout à l’autre. Ceci permet là encore de créer un interrupteur moléculaire ou même de construire une réplique de fibre musculaire. Une autre application est celle des colorants à longue durée de vie car la partie centrale de l’haltère est protégée par le cycle et ne peut pas être attaquée par des réactifs extérieurs risquant de la détruire. Ces drôles d’assemblages moléculaires sont susceptibles d’avoir des propriétés encore insoupçonnables mais on peut penser à eux en tant que vecteurs pour amener des médicaments exactement sur le lieu de leur cible.

Les deux autres lauréats du prix Nobel, Bernard Féringer, de l’université de Groninge aux Pays-Bas, et James Fraser Stoddart, de la Northwestern University aux Etats-Unis, ont quant à eux réalisé respectivement le rotaxane et des systèmes avec des pales tournant dans le même sens ainsi que l’olympiadane.